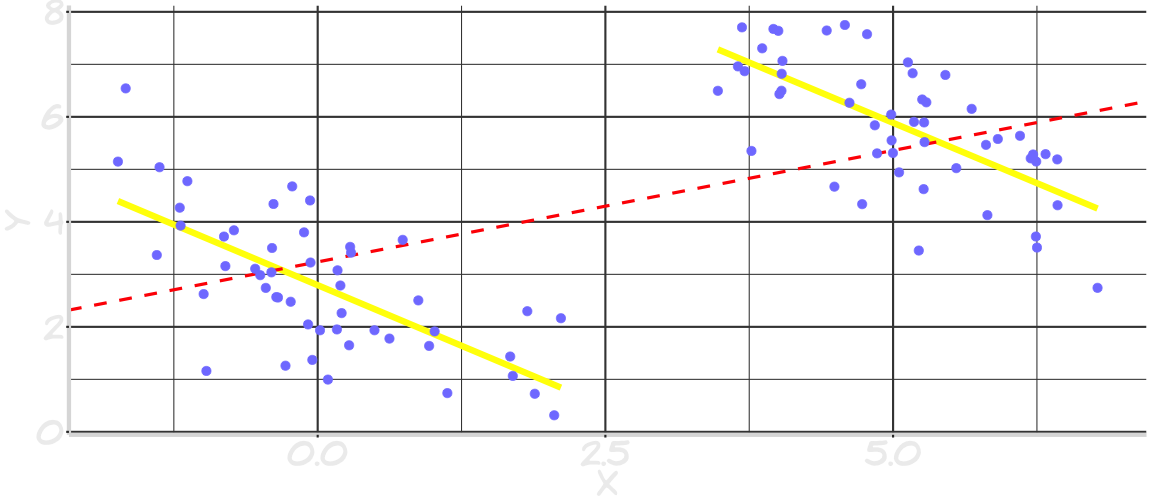

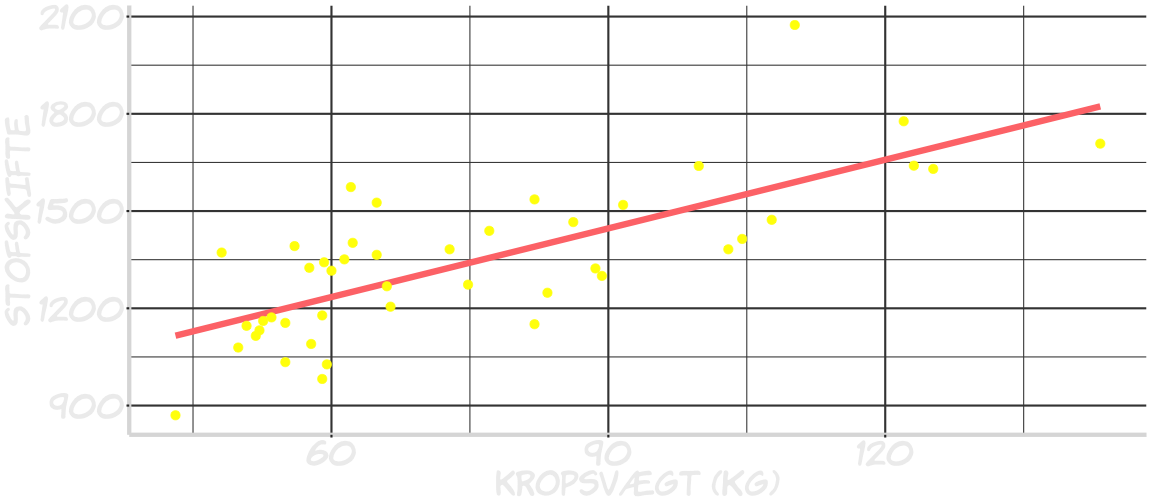

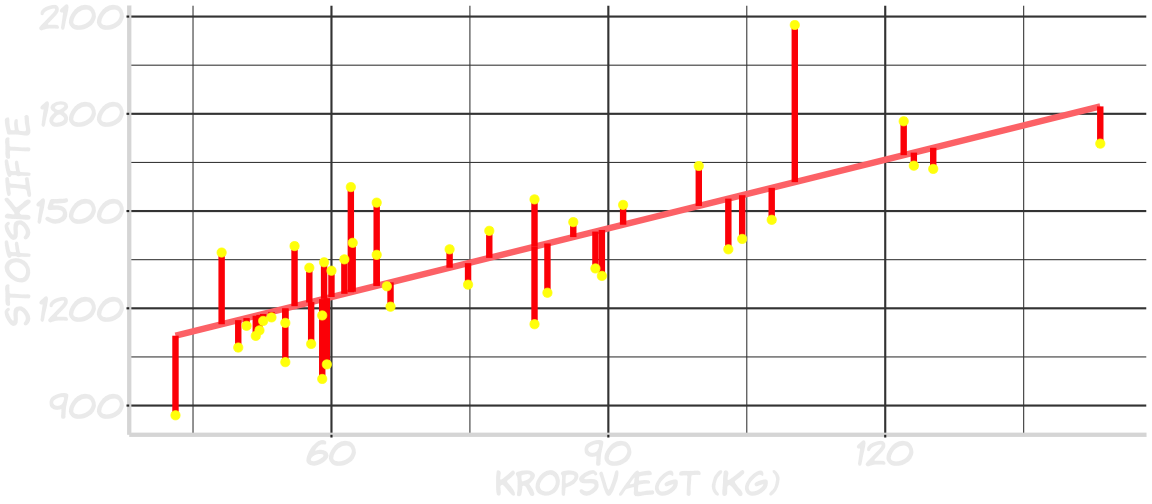

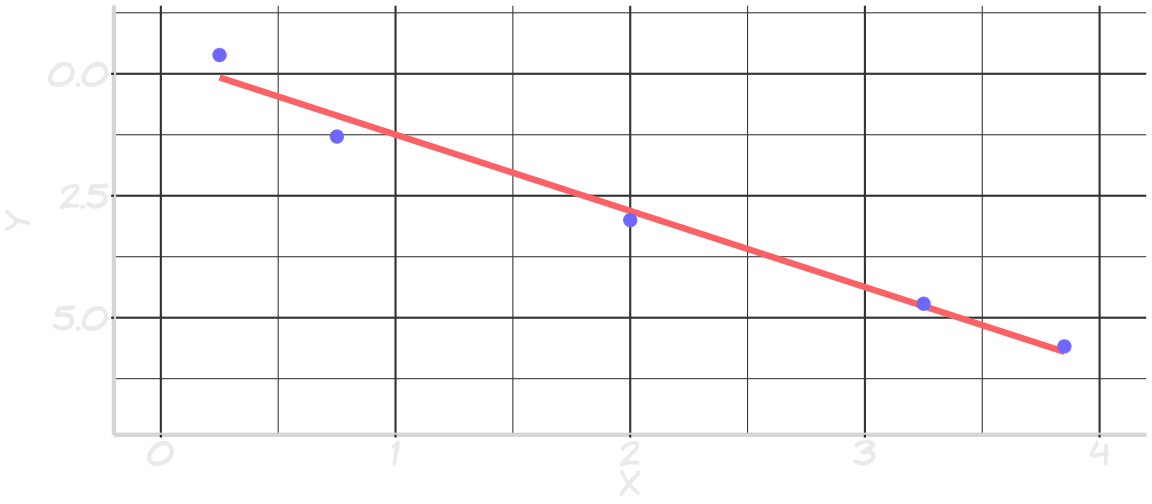

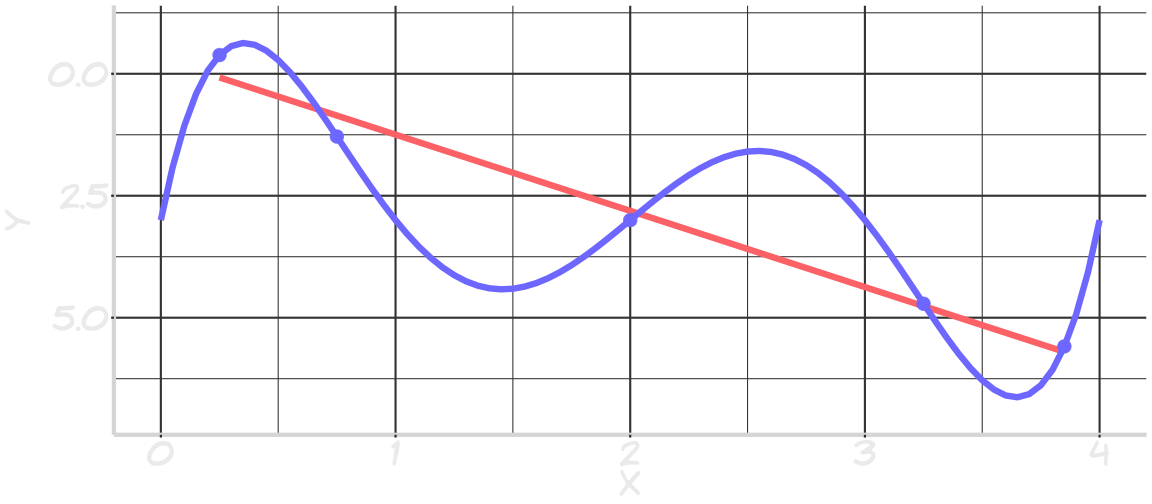

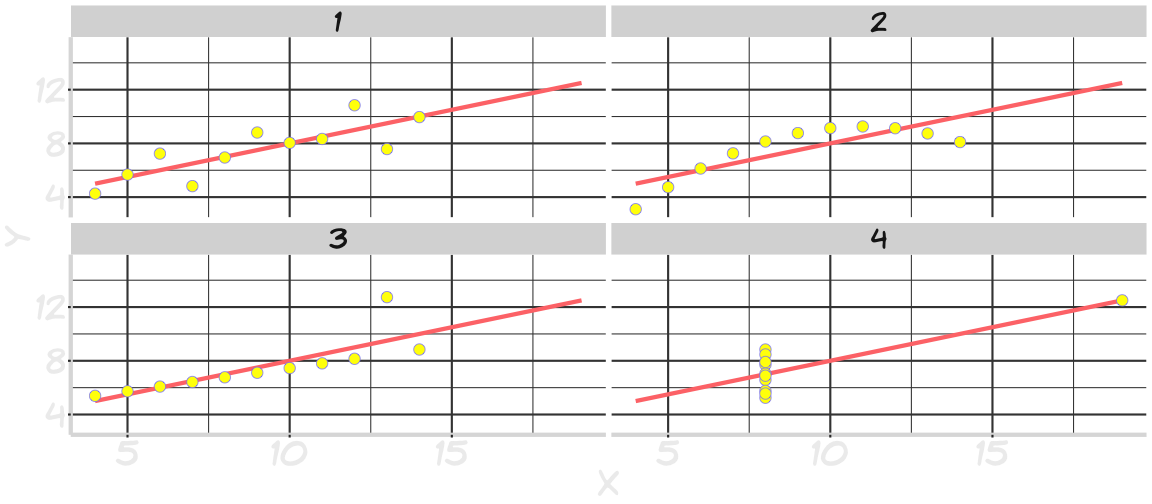

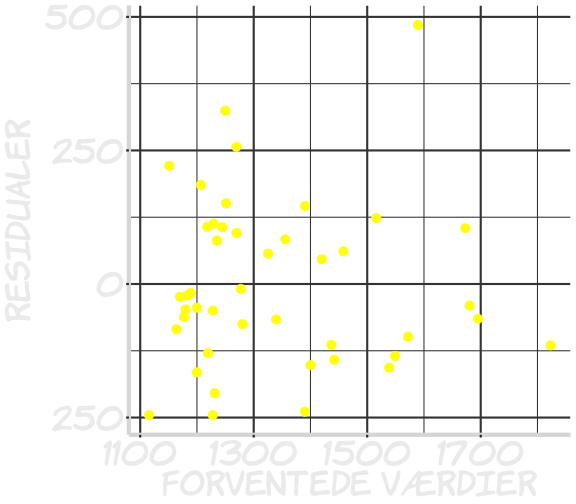

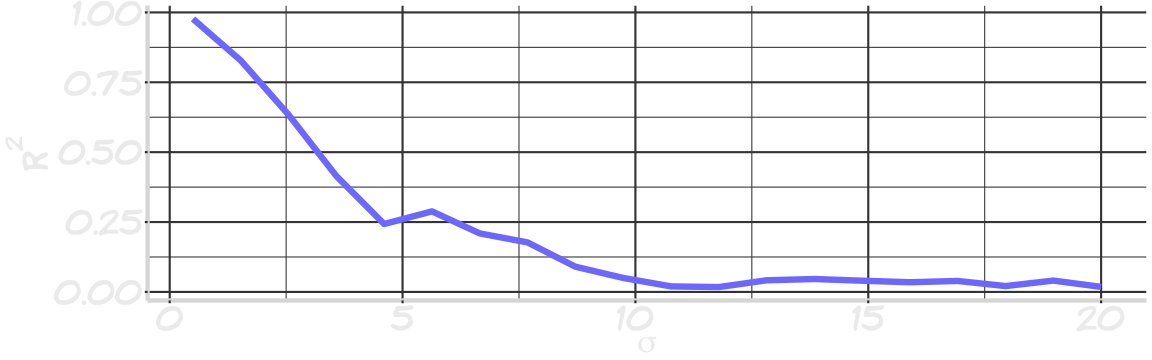

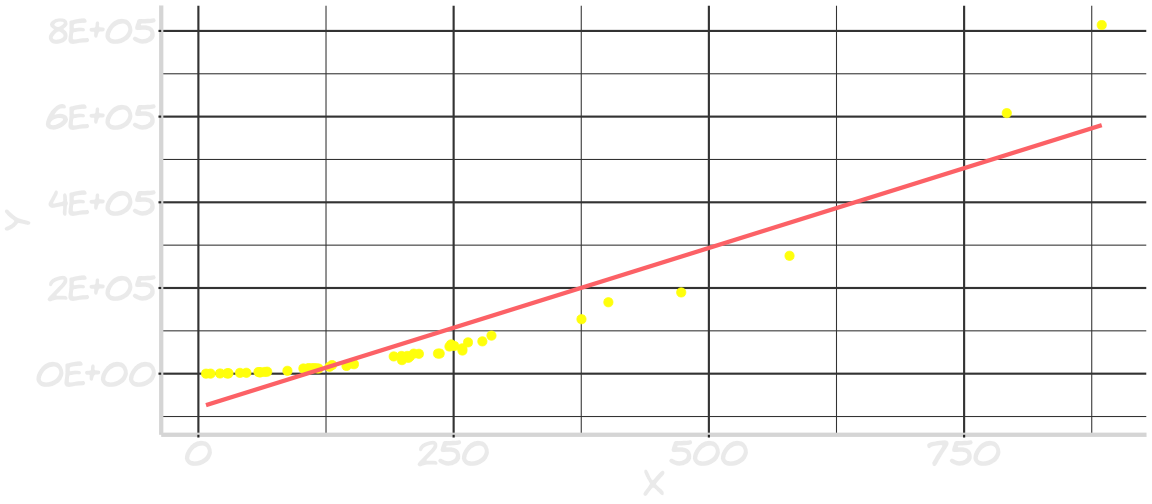

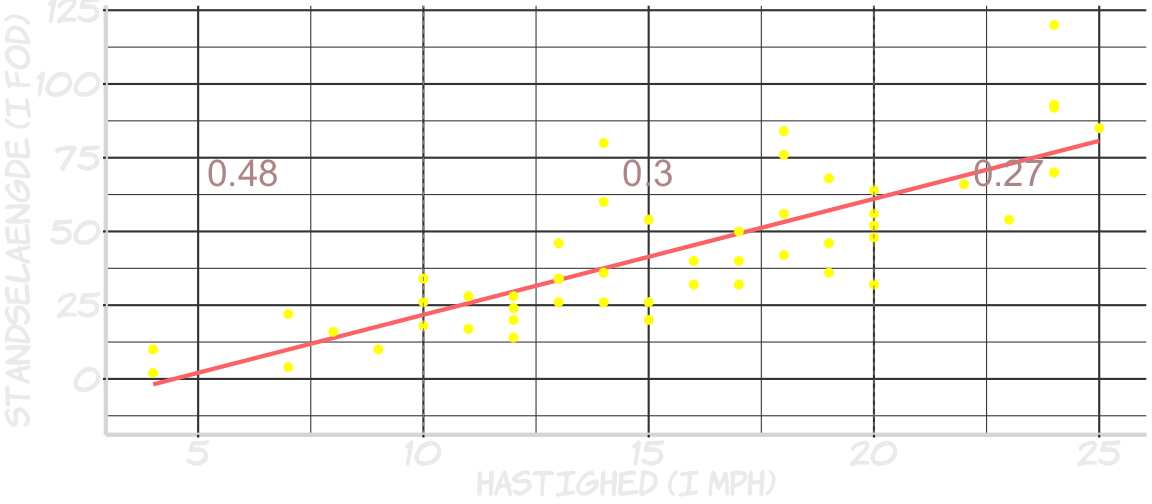

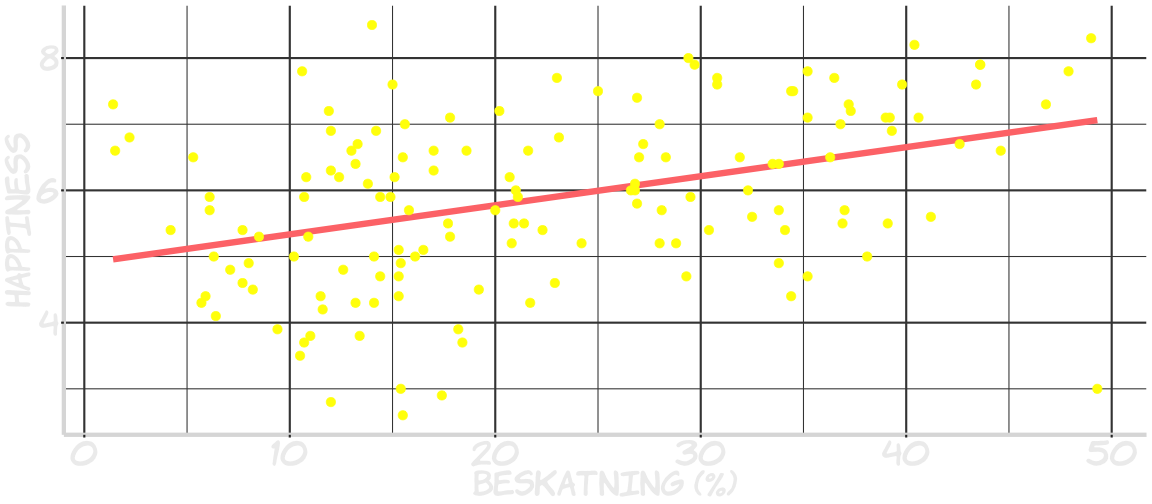

class: center, middle, inverse, title-slide # Statistisk modellering og regressionsanalyse ### Claus Thorn Ekstrøm<br>KU Biostatistik<br>.small[<a href="mailto:ekstrom@sund.ku.dk" class="email">ekstrom@sund.ku.dk</a>] ### Marts 18, 2019<br>.small[Slides @ <a href="www.biostatistics.dk/talks/">biostatistics.dk/talks/</a>] --- background-image: url("pics/trafik.jpg") background-size: 100% ??? I 1977 da jeg var 6 i børnehaveklassen skulle vi tegne, hvad vi ville være. Jeg ville være detektik eller brandmand. Kan huske det pga hunden. Jeg var rigtig glad for matematik i folkeskolen, i gymnasiet. Fulgte Anita. Læste matematik + statistik på KU. Skrev mit speciale om Pruitts estimator ... følte mig dum. Ingen ville hyre mig Spurgte om jeg ville lave phd om statistiske metoder i genetik. Lidt tilfældigt jeg er her. I har sikkert samme type baggrundshistorie. +++ Alle mennesker er statistikere. Statistik ... indsamle, præsentere, analysere og fortolke numeriske data ... effektive konklusioner. Kan jeg overleve at krydse vejen? --- # Hvad er statistik? > *Statistics is a science, not a branch of mathematics, but uses mathematical models as an essential tool.* > > .pull-left[ ] .pull-right[-- John Tukey] > og > *[...] data analysis is **detective work** - numerical detective work — or counting detective work — or graphical detective work.* > > .pull-right[-- John Tukey, 1977] ??? Numbers with context --- # Hvad bruger vi statistik til? .pull-left[ * **Mønstre**. <br> Hvad ser vi? * **Prædiktion**. <br> Hvad forventer vi ved ny observation? * **Kausalitet**. <br> Hvorfor? ] .pull-right[ <img src="pics/imaend.png" width="741" /> ] ??? 1) Gifte mænd lever længere end mænd, der er single. Det føles længere 2) Hvor stor er effekten? ca 7.5 år 3) Livsstil. Mænd, der er sundere og har bedre uddannelse, økonomi osv har større chance for at blive gift --- background-image: url("pics/gymbog.png") background-position: right background-size: 50% .small[.pull-left[ "Konklusionen er tvivlsom selv om graferne viser en tydelig sammenhæng" "Når man beder en hjælp fra en ekspert, får man ofte mere at vide, end man ønsker eller kan forstå" "Der er ikke fejl i udregningerne. Resultatet strider mod enhver sund fornuft, men det er ikke desto mindre rigtigt udregnet, ..." ]] ??? Kedeligt ... fokus på kausalitet, men ingen forklaring til, hvornår man kan opnå det 4.3 Eksempler på statistik Simpsons paradoks --- # "Strider mod enhver sund fornuft" <!-- --> --- background-image: url("pics/dontdoit.png") background-size: 100% ??? Move away from dice coins balls and urns. They are boring when we use equiprobable equipment it gives wrong ideas --- background-image: url("pics/ipopstik.png") background-size: 90% # Population og stikprøve --- background-image: url("pics/isandsynlighedvsstat.png") background-size: 90% ??? "I like the example of a jar of red and green jelly beans. A probabilist starts by knowing the proportion of each and lets say finds the probability of drawing a red jelly bean. A statistician infers the proportion of red jelly beans by sampling from the jar." Now the proportion of the red jelly bean obtained by sampling from the jar is used by the probabilist to find the probability of drawing a red bean from the jar However, probability theory contains much that is mostly of mathematical interest and not directly relevant to statistics. Moreover, many topics in statistics are independent of probability theory Probability: Given known parameters, find the probability of observing a particular set of data. Statistics: Given a particular set of observed data, make an inference about what the parameters might be. Statistics is "more subjective" and "more art than science" (relative to probability). In probability, the distribution is known and knowable in advance - you start with a known probability distribution function (or similar), and sample from it. In statistics, the distribution is unknown in advance. It may even be unknowable. Assumptions are hypothesised about the probability distribution behind observed data, in order to be able to apply probability theory to that data in order to know whether a null hypothesis about that data can be rejected or not. It's misleading to simply say that statistics is simply the inverse of probability. Yes, statistical questions are questions of inverse probability, but they are ill-posed inverse problems, and this makes a big difference in terms of how they are addressed. Probability is a branch of pure mathematics--probability questions can be posed and solved using axiomatic reasoning, and therefore there is one correct answer to any probability question. Statistical questions can be converted to probability questions by the use of probability models. Once we make certain assumptions about the mechanism generating the data, we can answer statistical questions using probability theory. HOWEVER, the proper formulation and checking of these probability models is just as important, or even more important, than the subsequent analysis of the problem using these models. One could say that statistics comprises of two parts. The first part is the question of how to formulate and evaluate probabilistic models for the problem; this endeavor lies within the domain of "philosophy of science". The second part is the question of obtaining answers after a certain model has been assumed. This part of statistics is indeed a matter of applied probability theory, and in practice, contains a fair deal of numerical analysis as well. --- # En model er en klasse af funktioner * `\(Y_i\)` - udfaldet * `\(f_\beta(x_i)\)` - den forventede værdi `$$\text{Model fx: } Y_i = \underbrace{\beta_0 + \beta_1\cdot x_i}_{f_\beta(x_i)} + \underbrace{\varepsilon_i}_{\text{Støj med middelværdi 0}}$$` Interessante spørgsmål: * Hvilke værdier af `\(\beta\)` vil gøre data mest sandsynlige (for fast `\(f\)`)? * Hvordan vælger man `\(f\)`? ??? --- # Hvilende stofskifte og kropsvægt <!-- --> --- # Residualer <!-- --> ??? Hvornår er en model god? Det er den, når man kan beskrive det man ser *OG* generaliseres til nye observationer *OG* fortolkes The negative and positive errors should cancel out ⇒ Zero overall error Many lines will satisfy this criterion --- # Mindste kvadraters metode Minimér de kvadratiske residualer `$$r_i = y_i - f_\beta(x_i)$$` `$$\arg\min\sum_{i=1}^N (y_i- f_\beta(x_i))^2$$` -- Hvor god er modellen? Prædiktionen? `$$\text{Observeret - forventet}$$` ??? Kendes også fra chi-i-anden * sum are non-negative * error is symmetric * squaring is smooth operation * ML --- background-image: url("pics/animation.gif") background-size: 90% --- # Fortolkning for lineær regression `$$Y_i = \beta_0 + \beta_1\cdot x_i + \varepsilon_i \; \; \; \; \Bbb{E}(\varepsilon_i)=0, \Bbb{V}(\varepsilon_i) = \sigma^2$$` * `\(\hat\beta_0\)` skæring * `\(\hat\beta_1\)` hældning * `\(\hat\sigma\)` spredning af residualerne `\(\beta_1\)` er den interessante parameter. Gennemsnitlig *relevante* effekt. `\(\beta_0\)` kun sjældent relevant. `\(\sigma\)` - hvor tæt er modellen og observationerne på hinanden --- # Spredningen `\(\hat\sigma\)` er kvadratroden af gennemsnittet af de kvadrerede afvigelser `$$\begin{split}\hat\sigma &= \sqrt{\frac{\sum_{i=1}^N (y_i - f_\beta(x_i))^2}{N}} = \sqrt{\frac{\sum_{i=1}^N r_i ^2}{N}}\end{split}$$` Men dette er i forhold til den *sande* model, hvor `\(\beta\)` er kendt. ??? Vi har jo ikke de sande parametre, men kun estimater fra stikprøven. Med andre ord vil estimaterne være lidt for tæt på værdierne i stikprøven. De passer lidt for godt. Hvis vi satte ind og brugte samme formel ville vi få for lille et estimat --- # Spredningen Hvis `\(\hat{y}_i\)` er den estimerede værdi for en måling `\(i\)` ud fra en statistisk model, så er residualspredningen `$$\begin{split}s &= \sqrt{\frac{\sum_{i=1}^N (y_i - \hat{y}_i)^2}{N-2}} = \sqrt{\frac{\sum_{i=1}^N \hat{r}_i ^2}{N-2}}\end{split}$$` hvor `\(\hat{r}_i = y_i - \hat{y}_i = y_i - \hat{\beta_0} + \hat{\beta_1}\cdot x_i\)`. Løst sagt: "Gennemsnitlig" afvigelse mellem observationerne og modellen. ??? Løs intuitiv forklaring på N-2 : hvis vi har to punkter har vi en linje, der passer perfekt. Det er først fra tredie punkt, at vi kan begynde at estimere spredningen. Enheden er det vigtigste. Kontekst. --- # Spredningen (the dirty business) LS estimaterne kan skrives som `\(\hat\beta = (X^\intercal X)^{-1}X^\intercal y\)` Sæt `\(H = \underbrace{X (X^\intercal X)^{-1}X^\intercal}_\text{Projektionen på søjlerne udspændt af X}\)`. Så er `$$\begin{split}\Bbb{V}(y - \hat{y}) = \Bbb{V}(y - X\hat\beta) &= \Bbb{V}( (I - H)y ) \\ &= (I - H)\Bbb{V}( y )(I - H)^\intercal \\ &= \sigma^2 (I - H)^2 \\ &= \sigma^2 (I - H) \end{split}$$` `\((I-H)\)` idempotent så rank=sporet, som er `\(n-p.\)` ??? I - H er Idempotent. Så er dens rang lig sporet X fuld rang I - H projektion på det ortogonale rum. Har rang n-p Variansenn af residualerne --- # Hvad fortæller en statistisk model? *Hvis* modellen er rimelig så fortæller den noget, om den *overordnede sammenhæng* i data. Fortæller ikke nødvendigvis noget om *årsagssammenhæng*. Det kan man nogle gange ud fra designet (RCT) og modellen (kausal inferens). Lineær regression fungerer på samme måde uanset om `\(X\)` er fast eller `\(X\)` observeret. ??? Hvornår er data rimelige? Eksempler på X fast eller obs. I fysik laver ... fejlkilder ... fysikrapporter X fast --- # Hvornår kan man løbe ind i problemer? * Hvis modellen er markant forkert. * `\(x\)` på `\(y\)` eller `\(y\)` på `\(x\)`? * Outliers. * Interpolation og ekstrapolation. * Fortolkning af skæringen. * Sammenhæng vs årsagssammenhæng. --- class: inverse, middle, center # Hvornår er en model god? # Hvornår er den rigtig? --- # Er lineær regression en god model her? <!-- --> --- # Er lineær regression en god model her? <!-- --> --- # Anscombes data <!-- --> Alle har hældning 0.5 og skæring 3. Og samme `\(R^2\)`! ??? Man skal tegne før man må regne --- # Datasaurus <!-- --> --- # Residualplot - er antagelserne opfyldte? .pull-left[ <!-- --> ] .pull-right[ 1. Middelværdi ca. 0 2. Ingen systematiske afvigelser 3. Check for outliers 4. Varianshomogenitet 5. (Uafhængighed - kan ikke nødvendigvis ses) ] --- # Er der så ikke noget rigtigt svar? .pull-left[ Næh. Eller jo ... Viden tilegnes ved, at en påstand stadig holder vand efter gentagne efterprøvninger. > *All models are wrong but some are useful* > .pull-right[ -- George Box] ] .pull-right[ <!-- --> ] ??? Fysisk model Smag på ordet. Det er en model trykte danmarkskort af dansk oprindelse. Det er tegnet af Marcus Jordan, som 1550-68 var professor i matematik ved Københavns Uni --- background-image: url(pics/lmfk.png) background-size: 80% --- # `\(R^2\)` fortæller ikke, hvor korrekt modellen er `$$R^2 = \frac{\beta_1^2 \Bbb{V}(X)}{\beta_1^2 \Bbb{V}(X) + \sigma^2}.$$` <!-- --> --- # En forkert model kan have `\(R^2\)` tæt på 1 <!-- --> `\(R^2 = 0.85\)` --- # Siger ikke noget om prædiktionsfejl `\(R^2=0.65\)` <!-- --> ??? Residualerne er de samme i alle områder --- # Sammenligninger `\(R^2\)` kan ikke bruges til at sammenligne modeller med utransformeret `\(Y\)` med en model med transformerede `\(Y\)` **Kan** bruges til at sige noget om forskellige modeller (med samme kompleksitet) med *samme* udfald. Men det kan spredningen også. --- background-image: url("pics/sandsynligivs.png") background-size: 40% class: center .Large[sandsynlig**vis**.dk] --- # Beskatning og happiness <!-- --> ??? Øverst til højre: DK Nederst til højre: Zimbabwe